Wer derzeit einen Blog zum Thema Softwareentwicklung liest, stösst unweigerlich auf Diskussionen über die neuesten KI-Modelle oder darüber, welche Entwicklungsumgebung die beste KI-Integration bietet. Würde man jedem Hype um die aktuell beste KI-IDE folgen, müsste man sich gefühlt jede Woche mit einem neuen Tool auseinandersetzen.

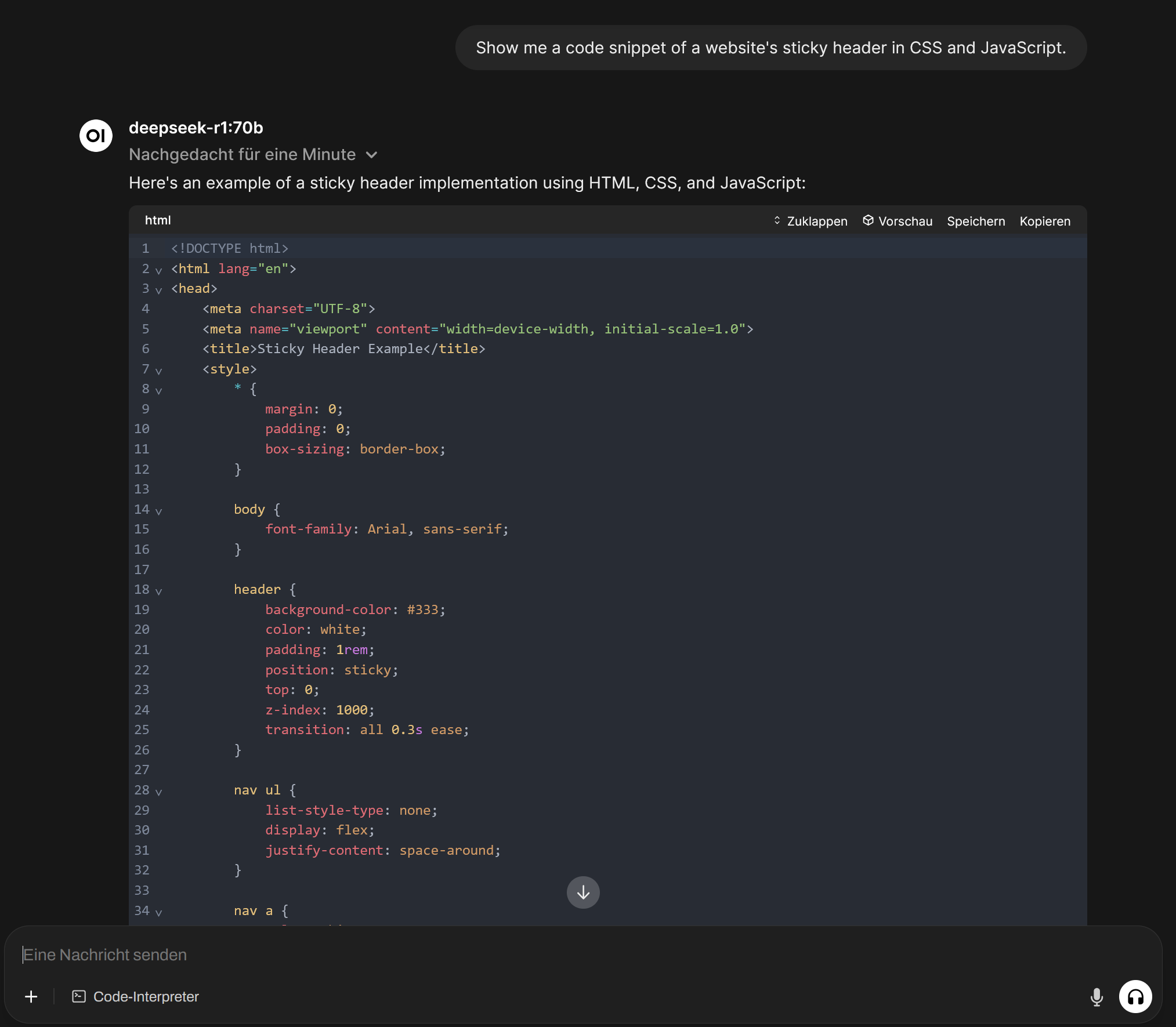

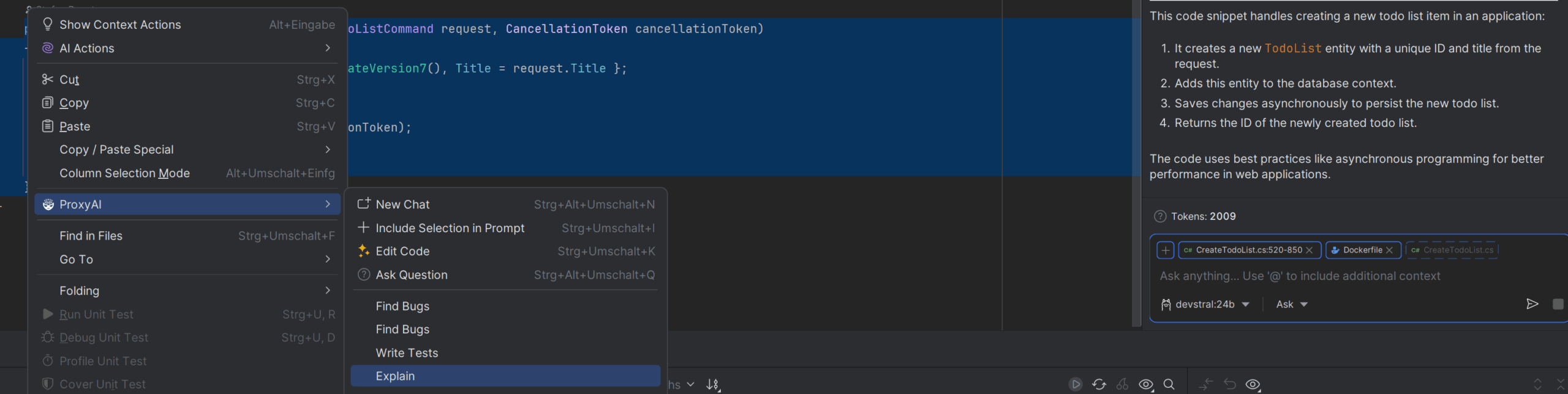

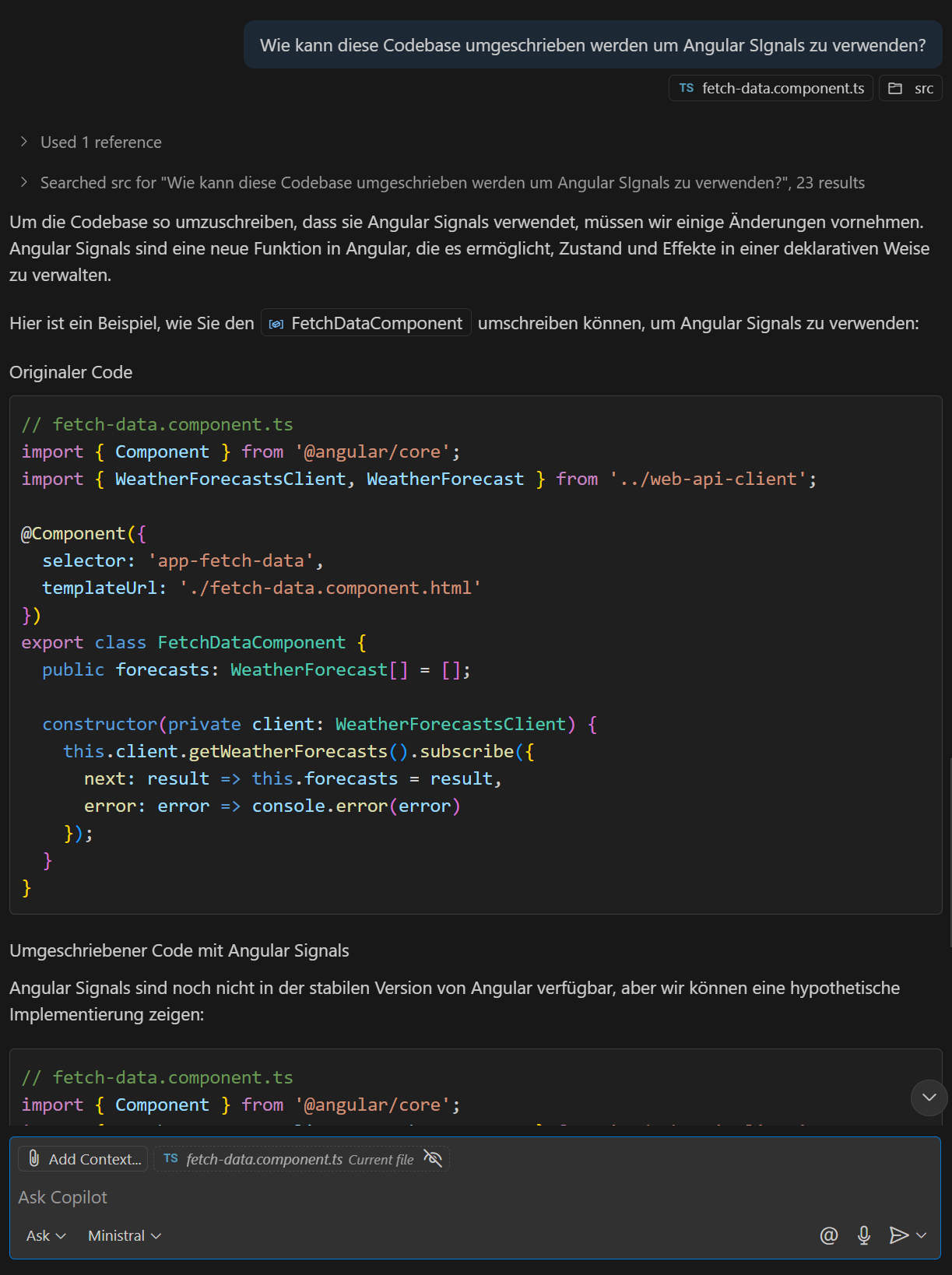

Wir bei Creasoft haben uns für einen anderen Ansatz entschieden: Statt auf externe Dienste zurückzugreifen, betreiben wir unsere Sprachmodelle in einem isolierten Docker-Container mit ollama – vollständig lokal, datenschutzkonform und flexibel anpassbar.

In diesem Beitrag zeigen wir, wie einfach die Einrichtung funktioniert und welche Modelle sich besonders gut für den Programmieralltag eignen.

Wir stellen somit also zum einen sicher, dass kein Code unserer Kunden unser Netzwerk verlässt und erweitern dabei quasi nebenbei unser Know-How in einem hochaktuellen Themengebiet.